흠

'Life' 카테고리의 다른 글

| 250101 일상#1. 무제 (1) | 2025.01.01 |

|---|---|

| 나머지정리 (0) | 2024.12.10 |

| 방어기제 (0) | 2024.12.02 |

| [완강][패스트캠퍼스] 대규모 언어모델 LLAMA를 활용한 프로젝트 구현과 Fine tuning - 후기 (0) | 2023.12.13 |

| 스팀덱 샀다. (0) | 2022.12.31 |

흠

| 250101 일상#1. 무제 (1) | 2025.01.01 |

|---|---|

| 나머지정리 (0) | 2024.12.10 |

| 방어기제 (0) | 2024.12.02 |

| [완강][패스트캠퍼스] 대규모 언어모델 LLAMA를 활용한 프로젝트 구현과 Fine tuning - 후기 (0) | 2023.12.13 |

| 스팀덱 샀다. (0) | 2022.12.31 |

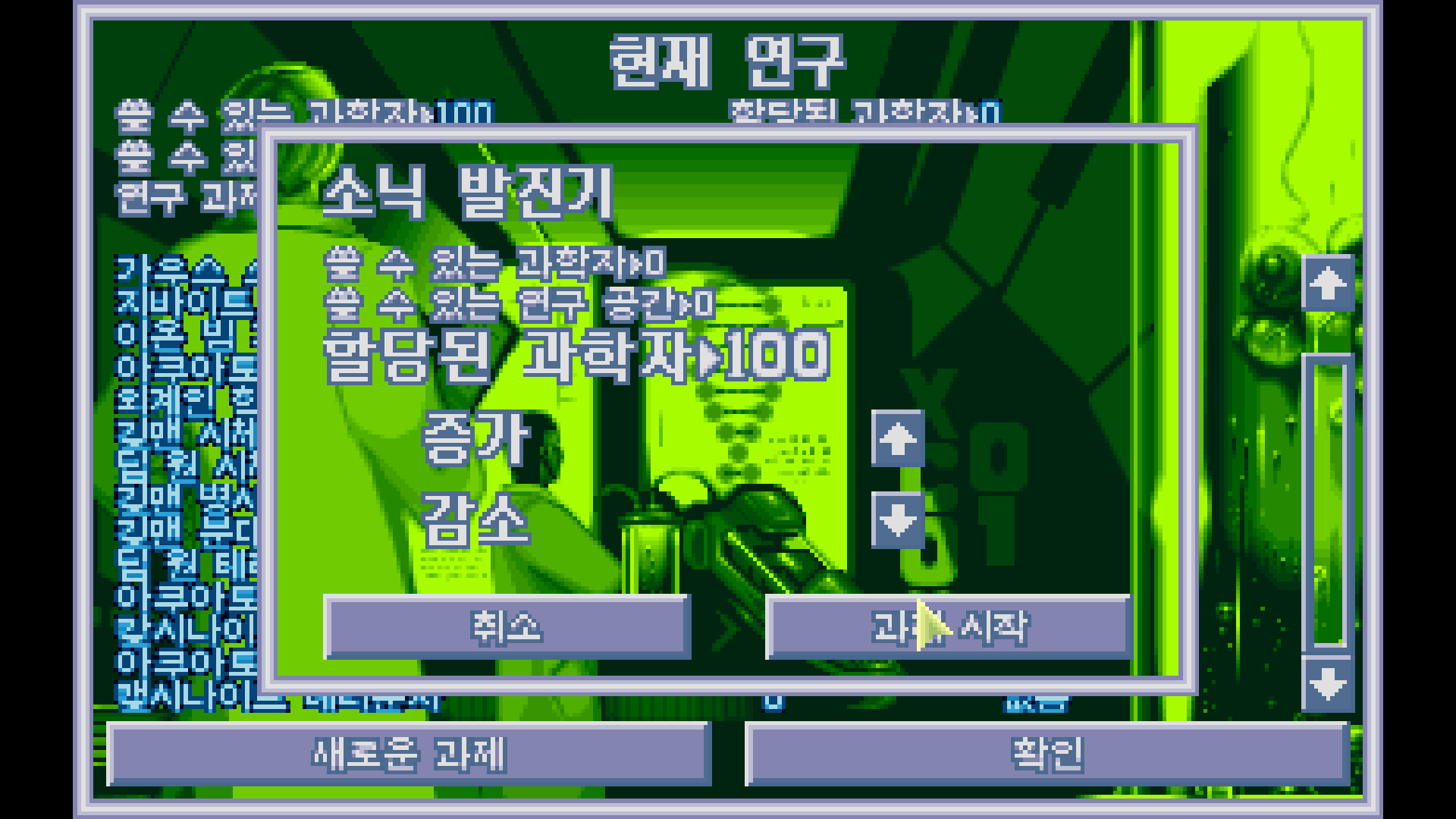

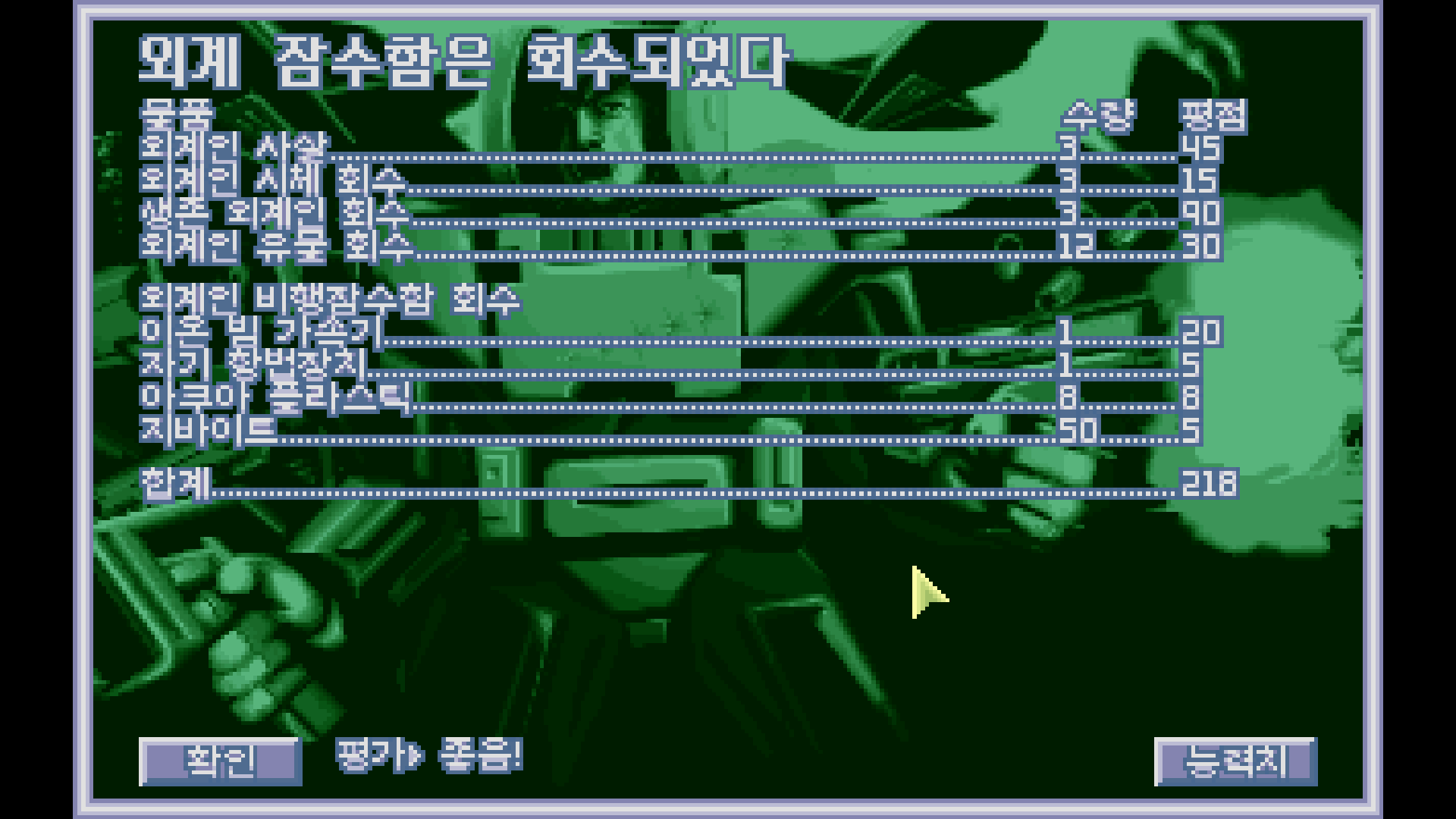

소닉 발진기에 꽂아주자.

.

알았다.

.

기술자는 될때마다 산다.

.

보급순양함. 털 수는 없겠지만 도전....은 금방 사라졌네.

.

탄두 어뢰를 더 사야겠다.

.

기술자는 생길 때마다 꽂는다.

.

또 가야지...........

는 하기 싫어.

저장하고 끝낼 것이다.

.

이제 그만!

XCOM 클래식은 볼거 다 봤다고 생각한다.

지금 와서 이걸 더 하는 건 자기만족이랑 시간낭비 밖에 되지 않는다.

XCOM 클래식은 여기까지 하기로 하자.

| TFTD (6) 과학자 100명을 만들어야 해 (0) | 2025.09.13 |

|---|---|

| TFTD (5) 소닉 무기 개발개발 (0) | 2025.09.12 |

| TFTD (4) 250만원 어디다 써야하냐 (0) | 2025.09.12 |

| TFTD (3) 아쿠아토이드, 길맨, 딥원 (0) | 2025.09.12 |

| TFTD (2) 짱박히는 적과 불합리한 난이도 (0) | 2025.09.12 |

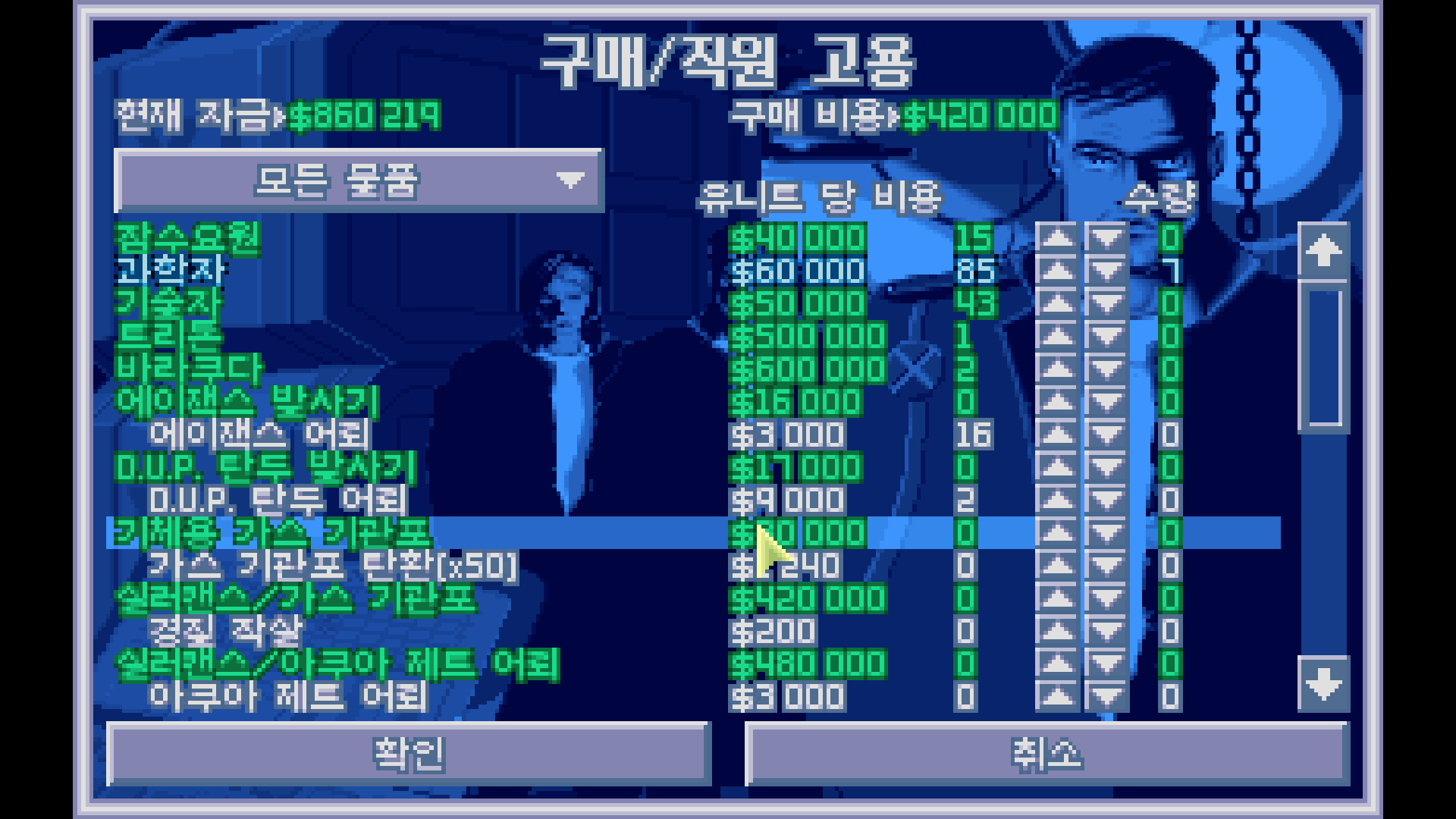

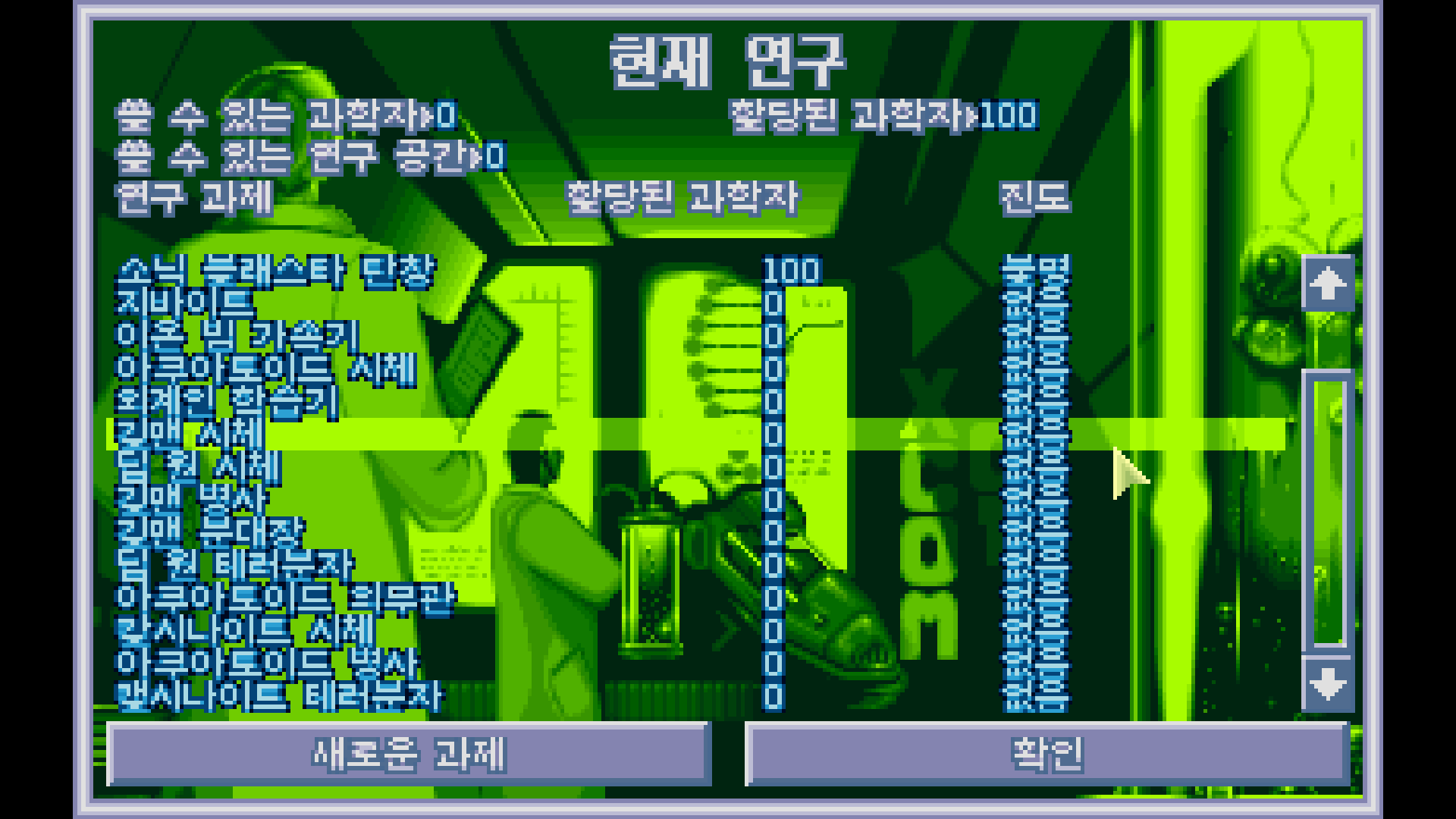

과학자 사버리자.

.

으흐흐흐

.

착륙 지점으로 가서 강습을 합시다.

.

한참을 뒤졌더니 이제야 나오네

.

뭐 적당히 마무리 했다.

근데 애들 짱박히는 거 열받는다

아니 그럴거면 항복해서 생포된 외계인이라도 하시던가요

.

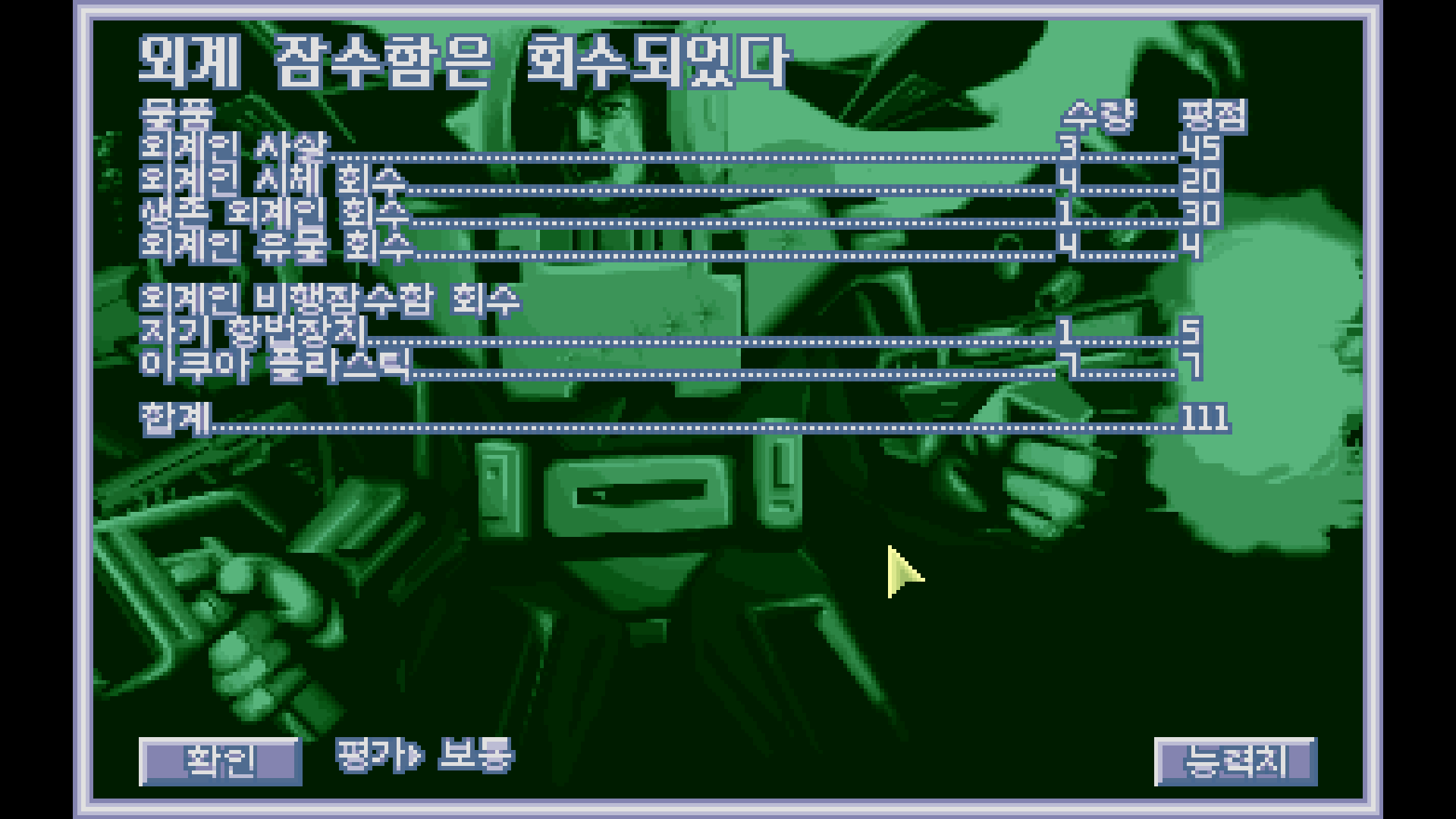

능력치 상승은 적당히.

.

과학자는 재깍재깍 사주자.

.

병사는 없는 희한한 군대 체계...

.

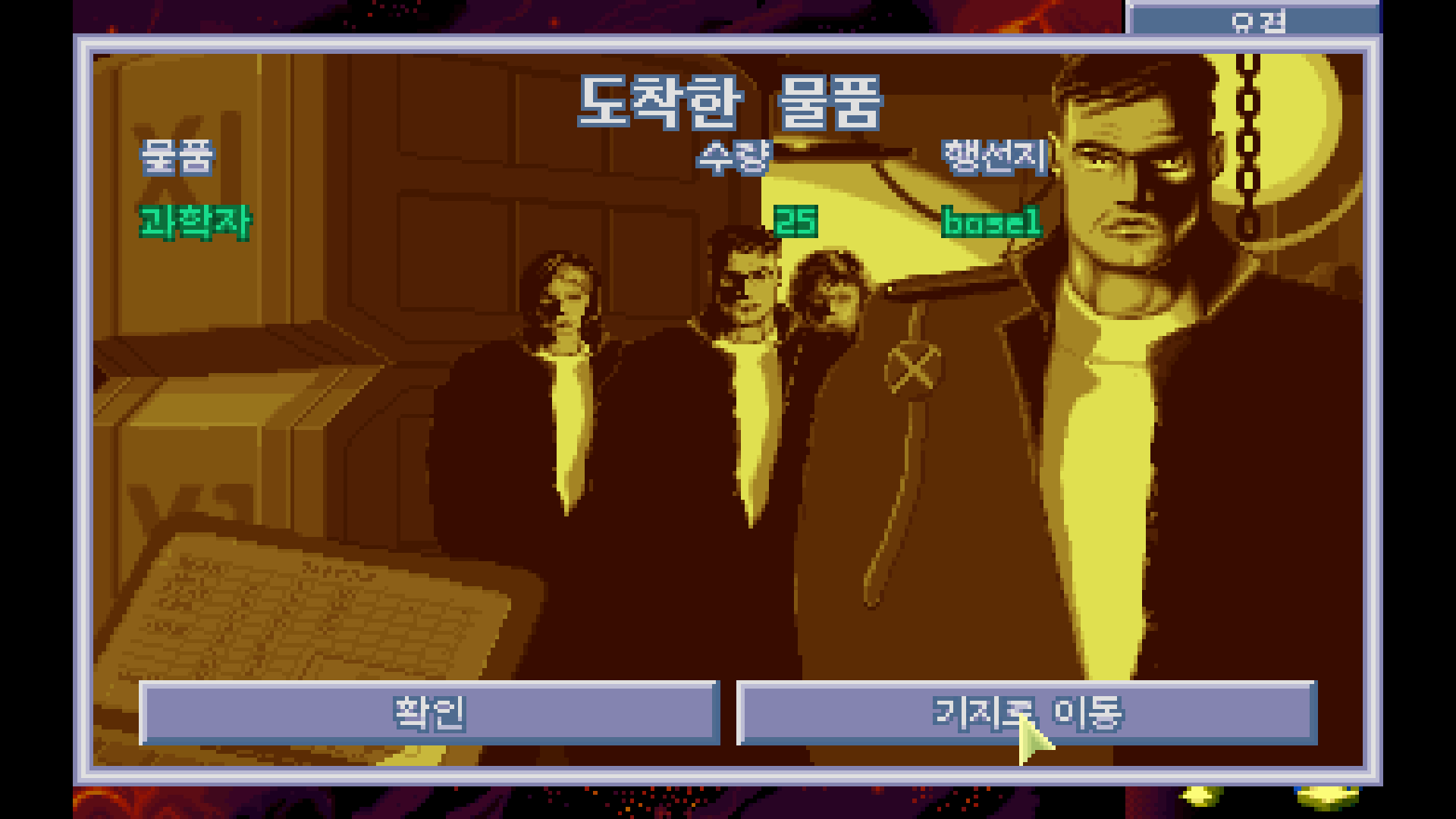

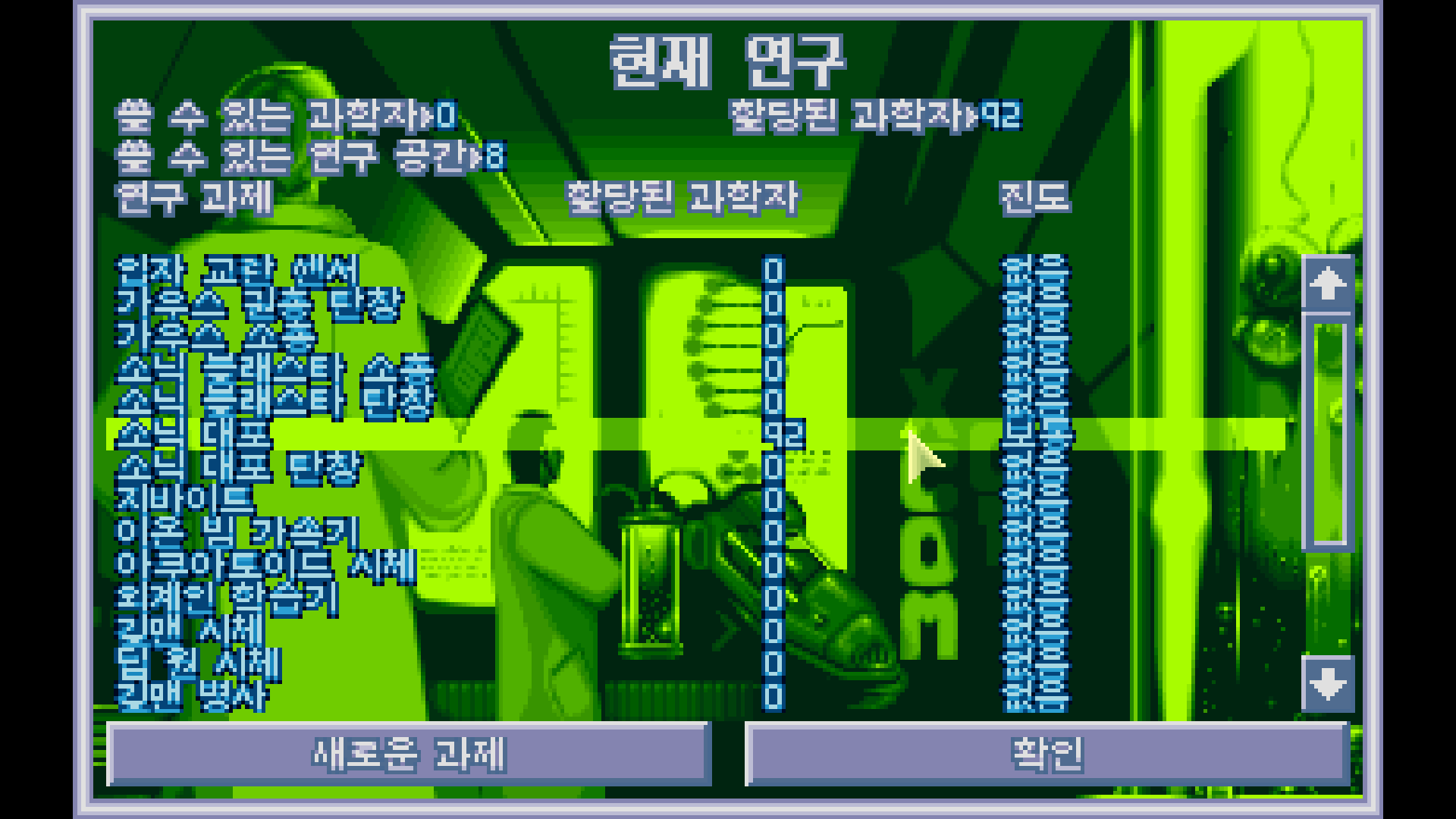

주문했던 과학자들을 모아서,

.

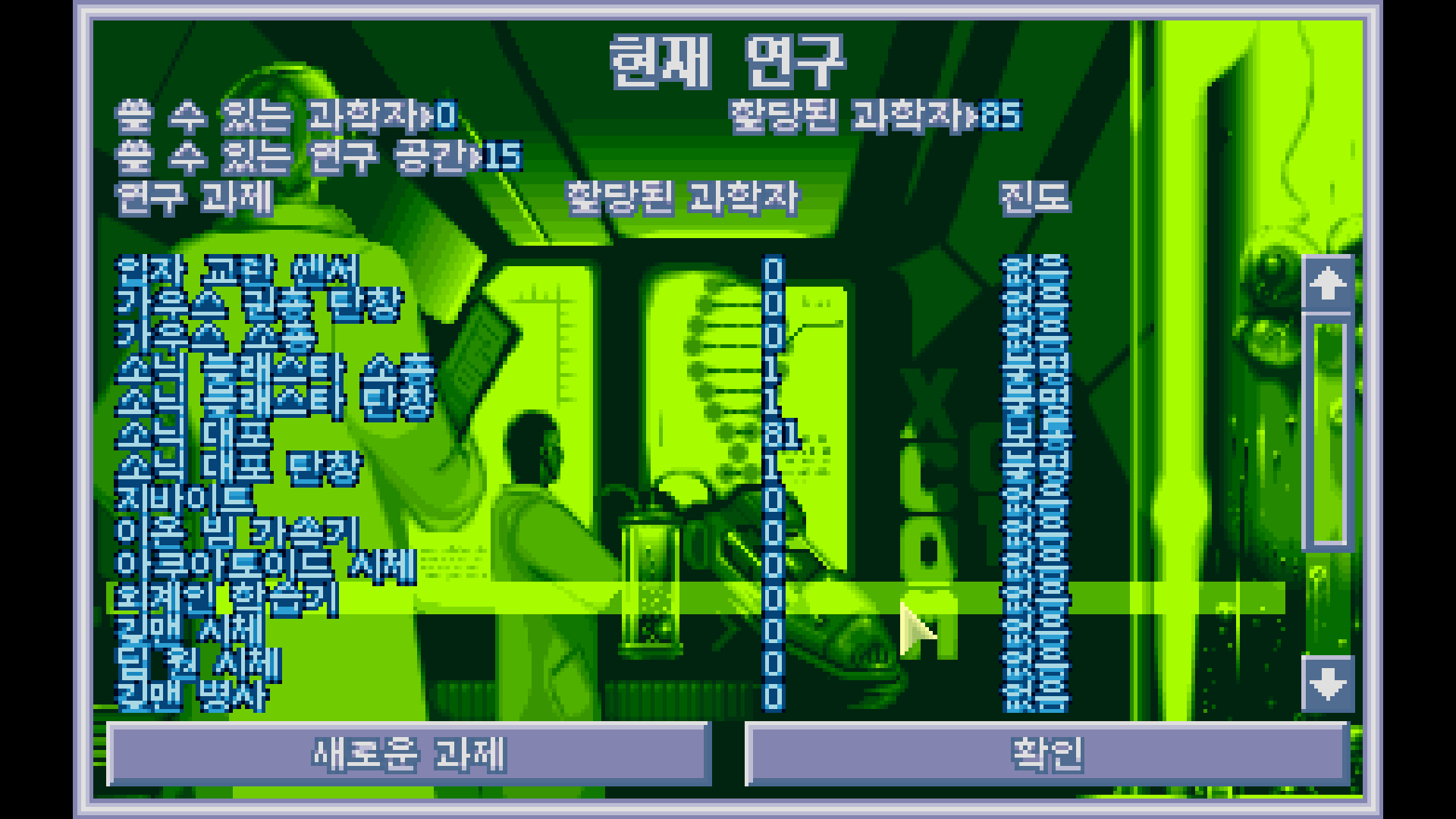

소닉 대포에 넣어주자.

.

추가된 7명의 과학자까지.

.

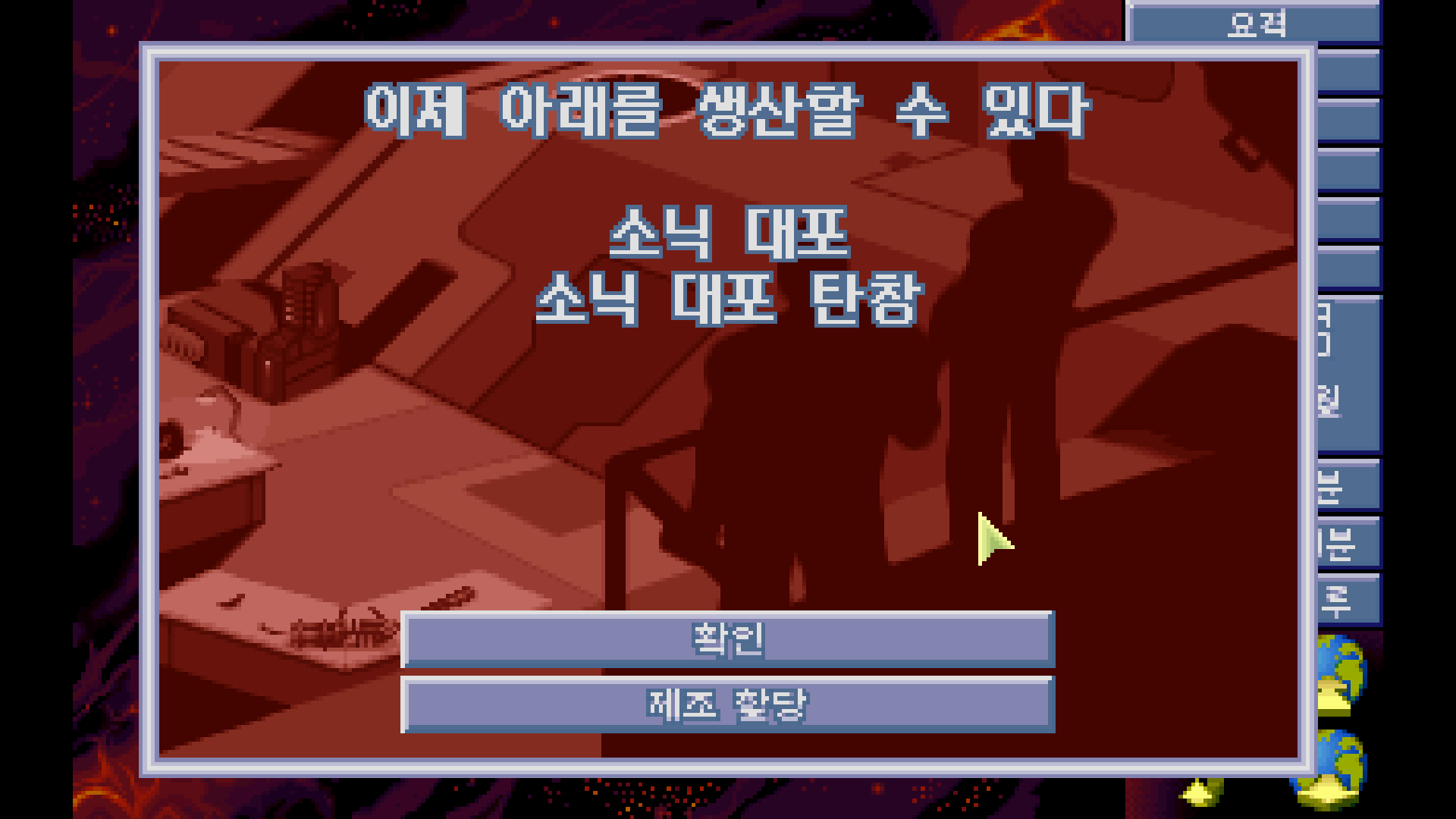

연구 완료!

.

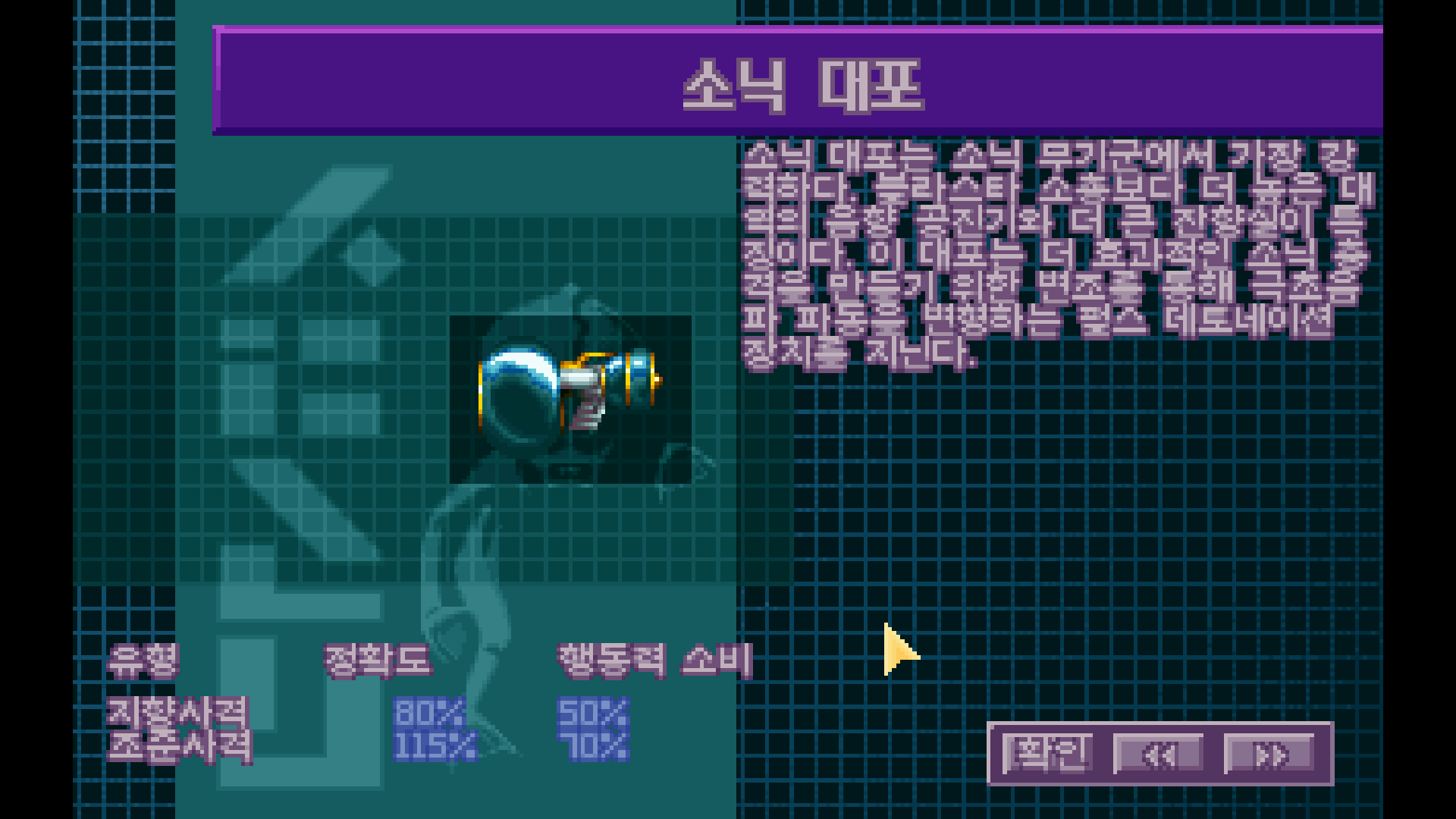

정확도가 엄청 높다! 행동력 소비는 좀 많구만.

.

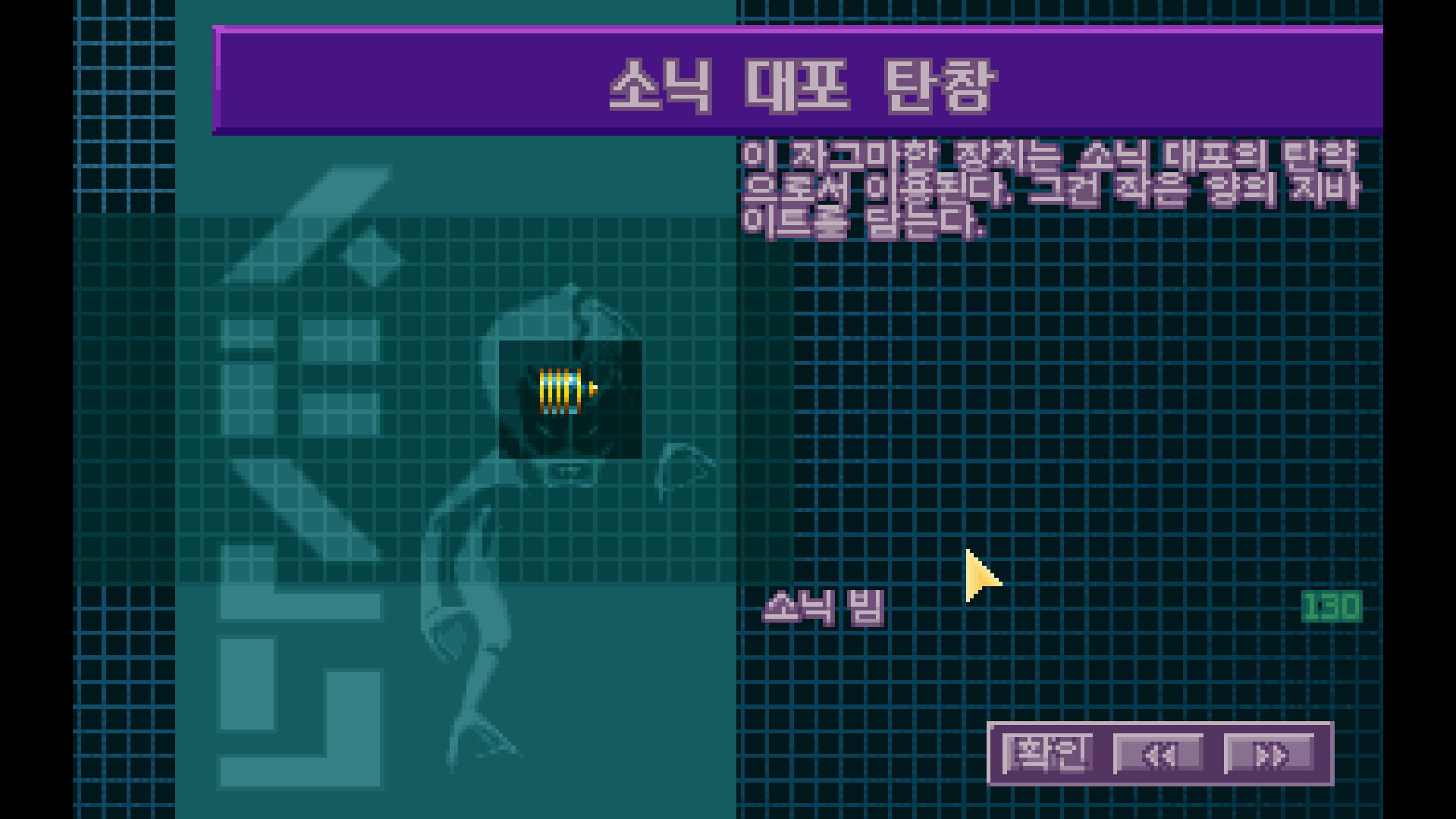

소닉 대포 탄창

의 연구를 진행할까?

.

와씨 무기를 다 썼네??

.

좀 사주기는 해야겠다.

.

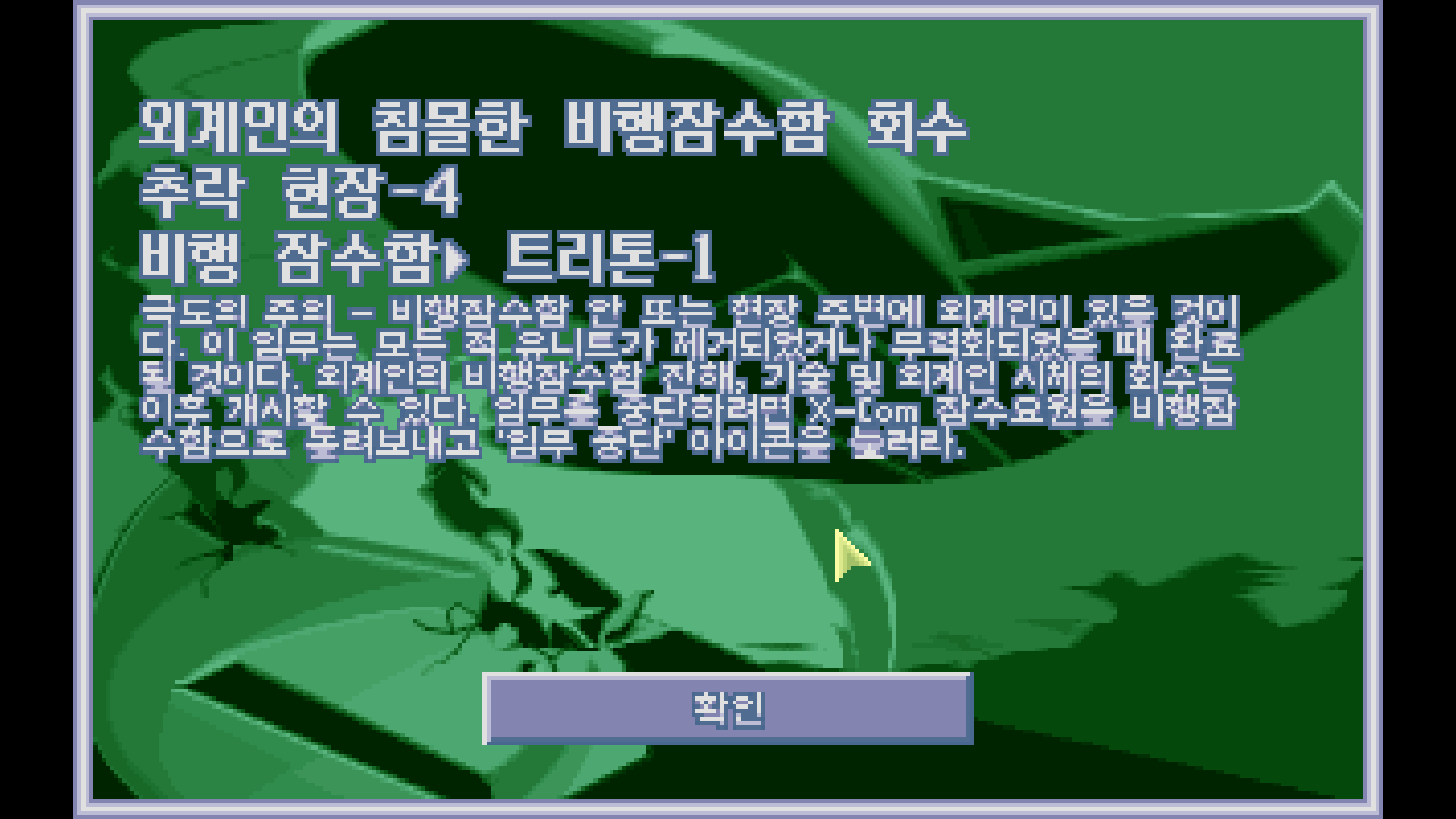

추락현장 3 처리.

.

이번엔 그래도 USO 가 가깝다.

.

잡아주고.

.

근데. 이 게임은 테마는 진짜 괜찮은데 말야.

애들 짱박히는 건 좀 말이 안 되게 짜증난다.

내가 이 게임을 굳이 해야 하나? 싶다.

솔직히 같은 게임을 스킨이랑 테마만 다르게 해서 파는 거잖아.

그러면 더 나아진 재미나 개선된 편의성을 보여야 되는 거잖아.

재미는 똑같을 수 있다고 치자. 그런데 어째서 이런 남은 적을 뒤지는 개노가다를 해야 하지?

.

뭐 그래.

.

그렇다.

솔직히 지금 이 게임 하고 있는 이유는 전투가 재밌는 게 아니다.

외계인 연구 보고서를 수집하는 게 지금 훨씬 재밌는 상황이다...

.

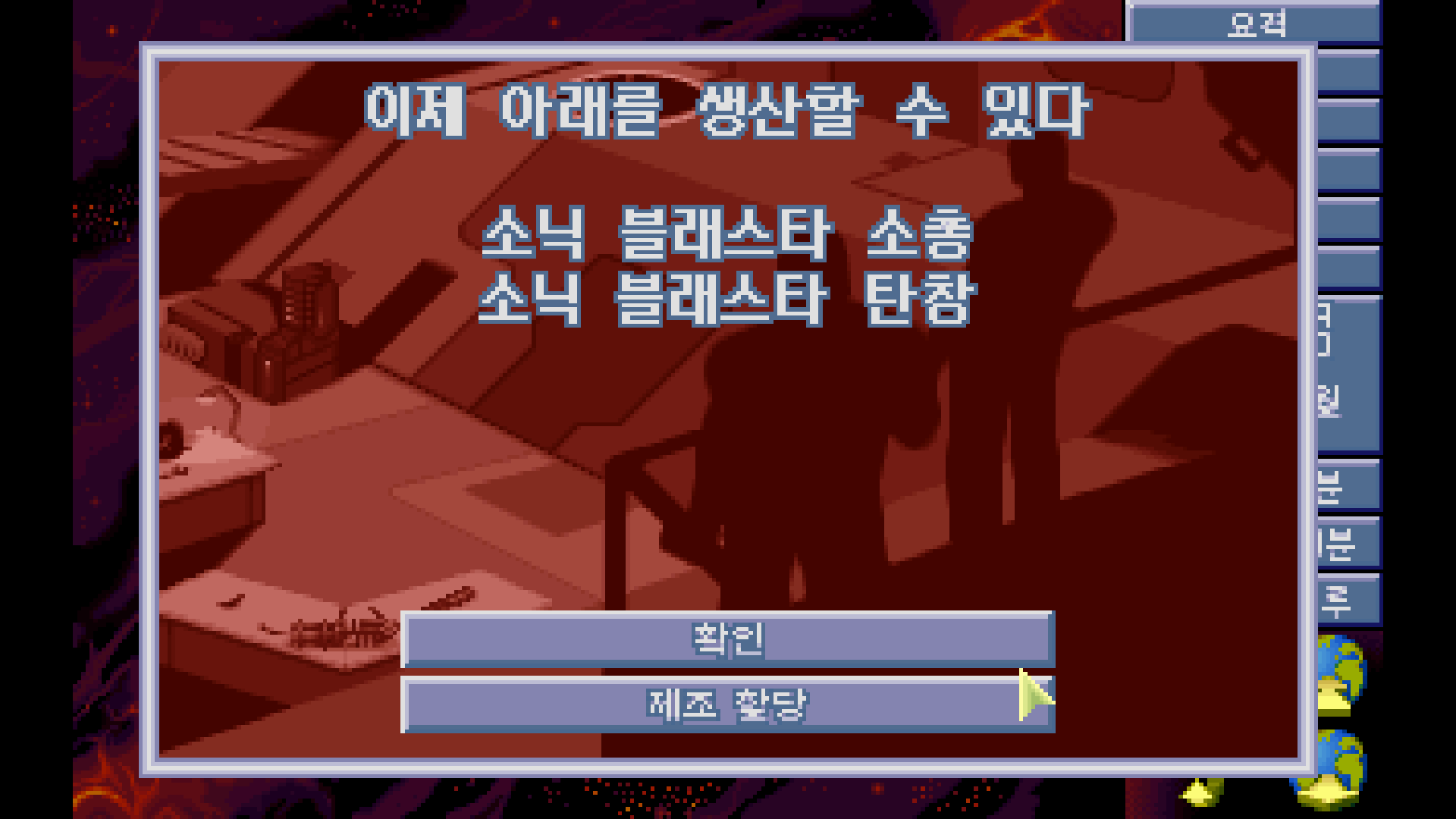

탄창도 완료 됐다. 연구는 블래스터 소총으로 넣었다.

.

생활관 건설이 완료됐다.

이제 할 일은... 과학자를 더 뽑는 거긴 한데.

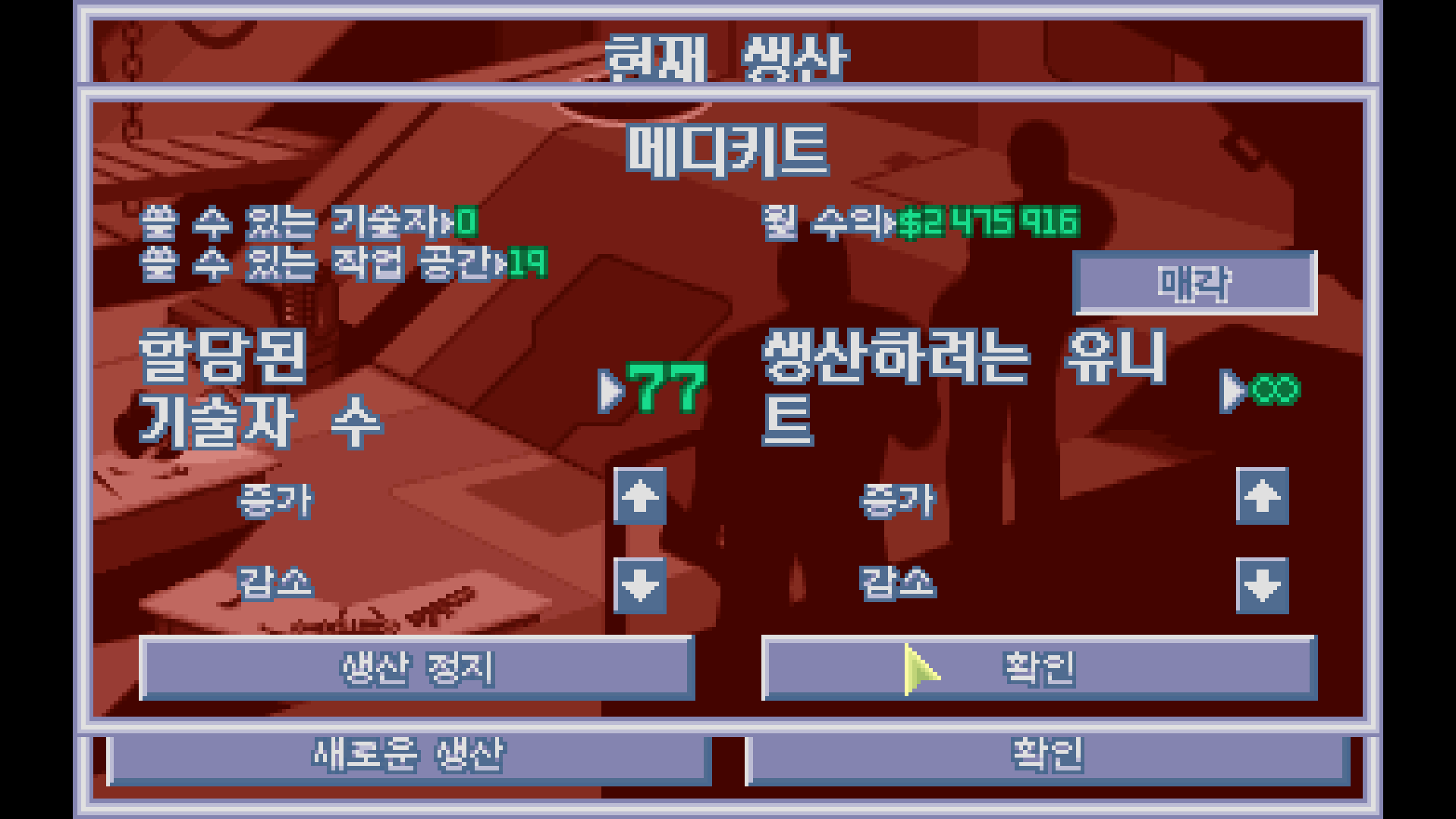

개인적으로 과학자보단 기술자를 더 뽑고 싶은 마음인걸.

.

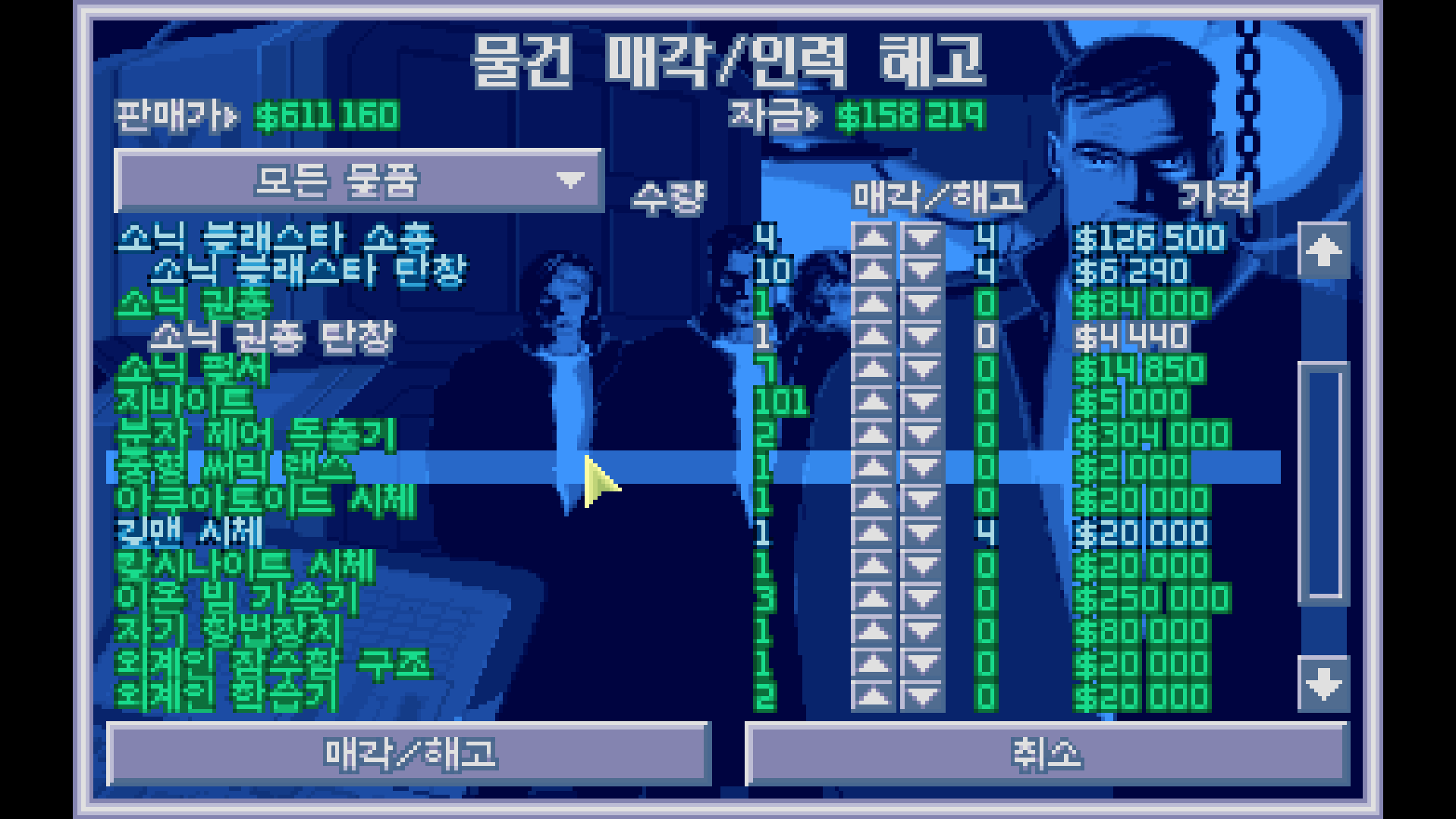

매각으로 돈을 벌었다.

.

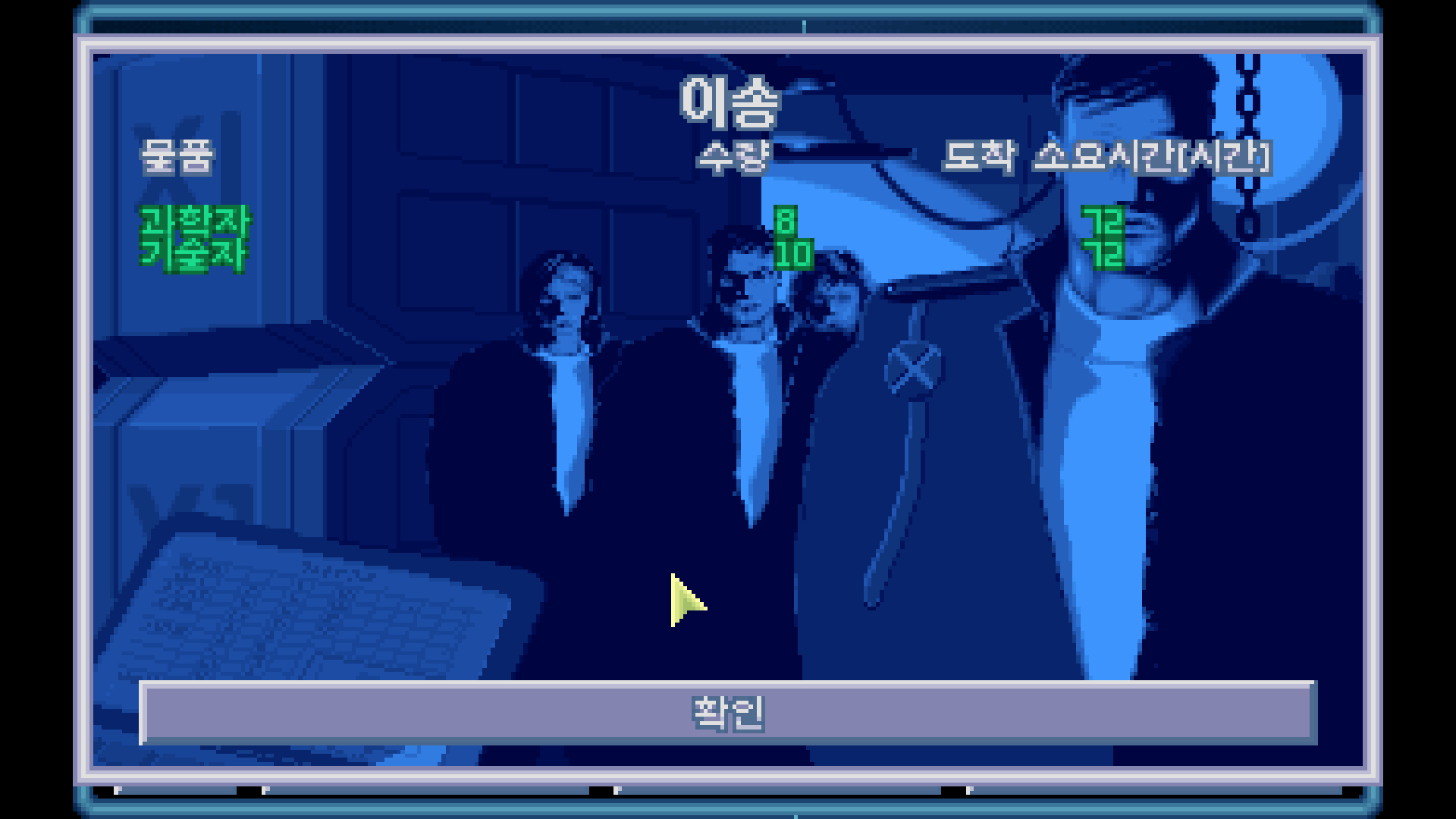

그래. 과학자를 100명 만들고, 이제 기술자만 만드는 테크로 가자. 맘편하게.

.

오는 데 걸리는 시간은 72 시간.

.

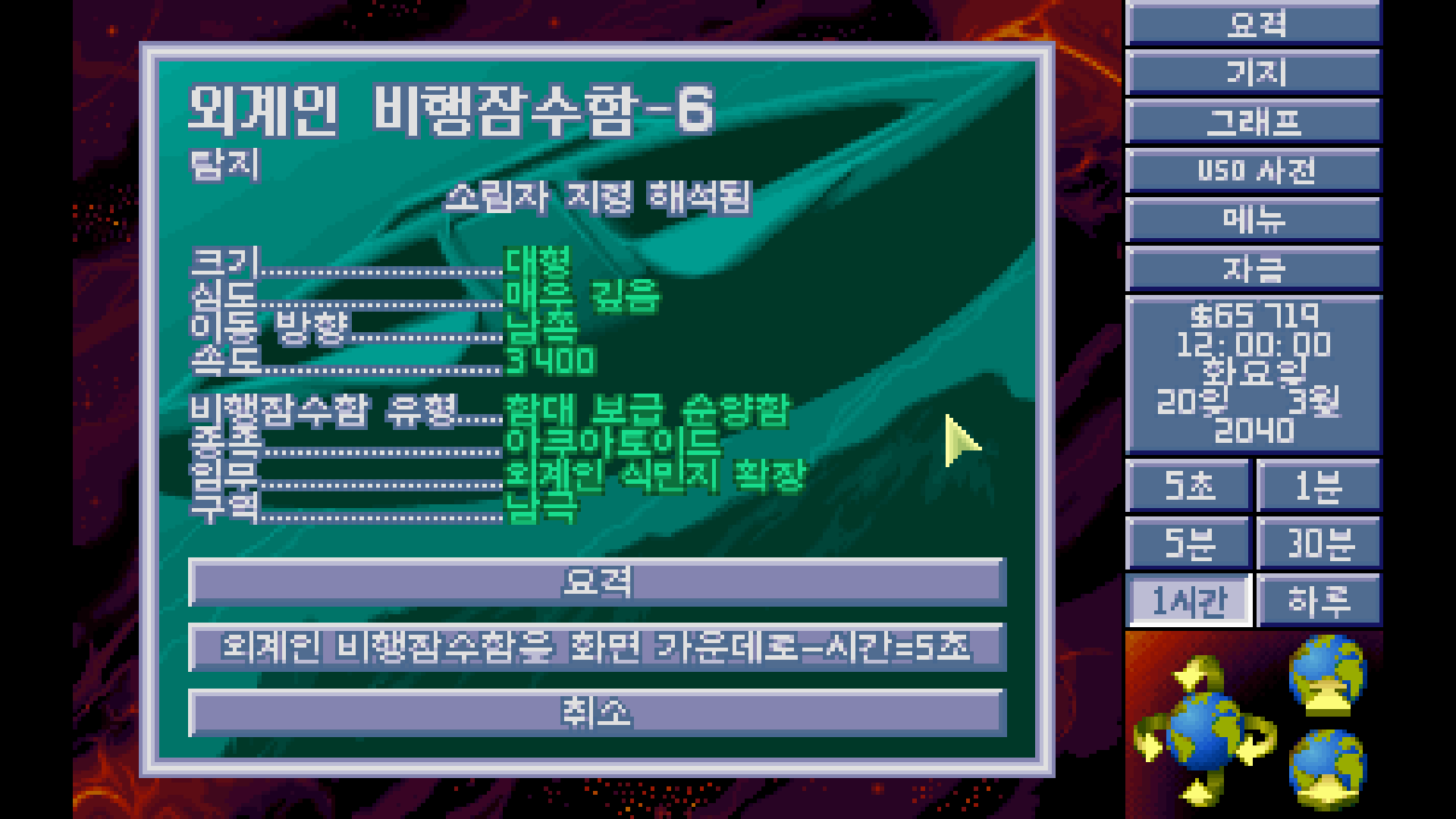

지령 해석기의 건설이 끝났다고 한다.

.

무슨 지령이 오가고 있을까?

.

3일 빨리 지나네;

.

메디키트에 꽂아준다.

.

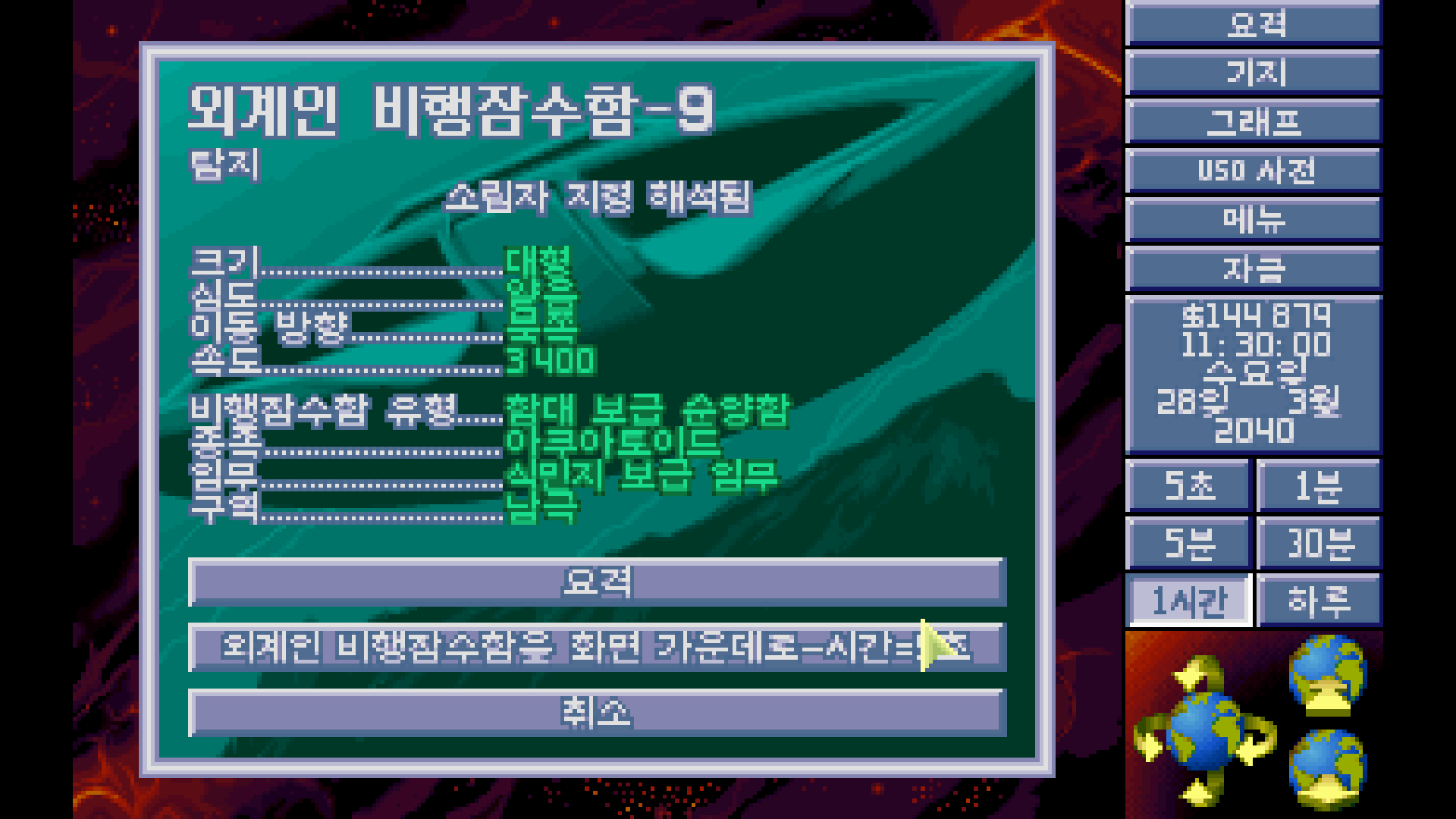

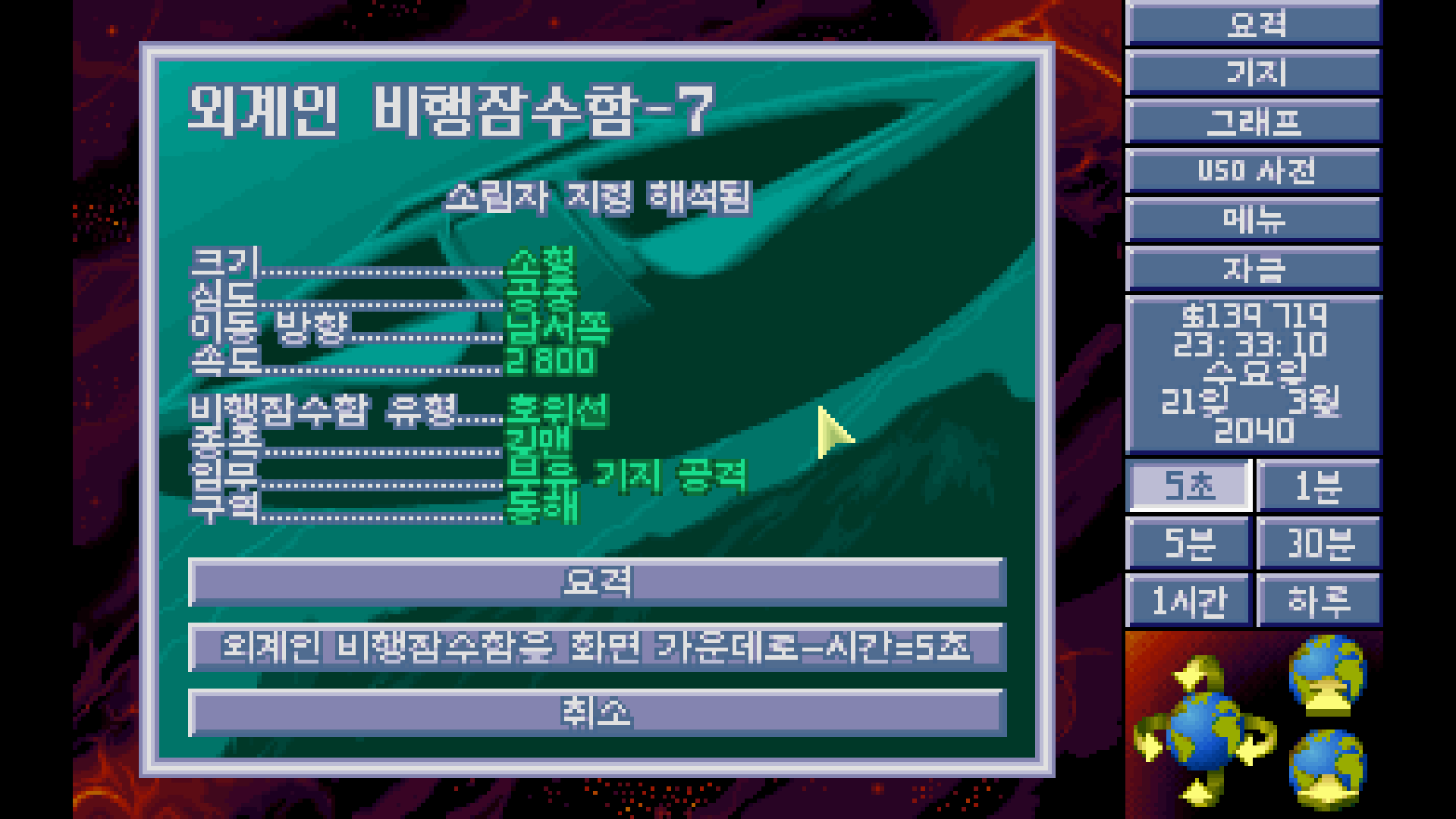

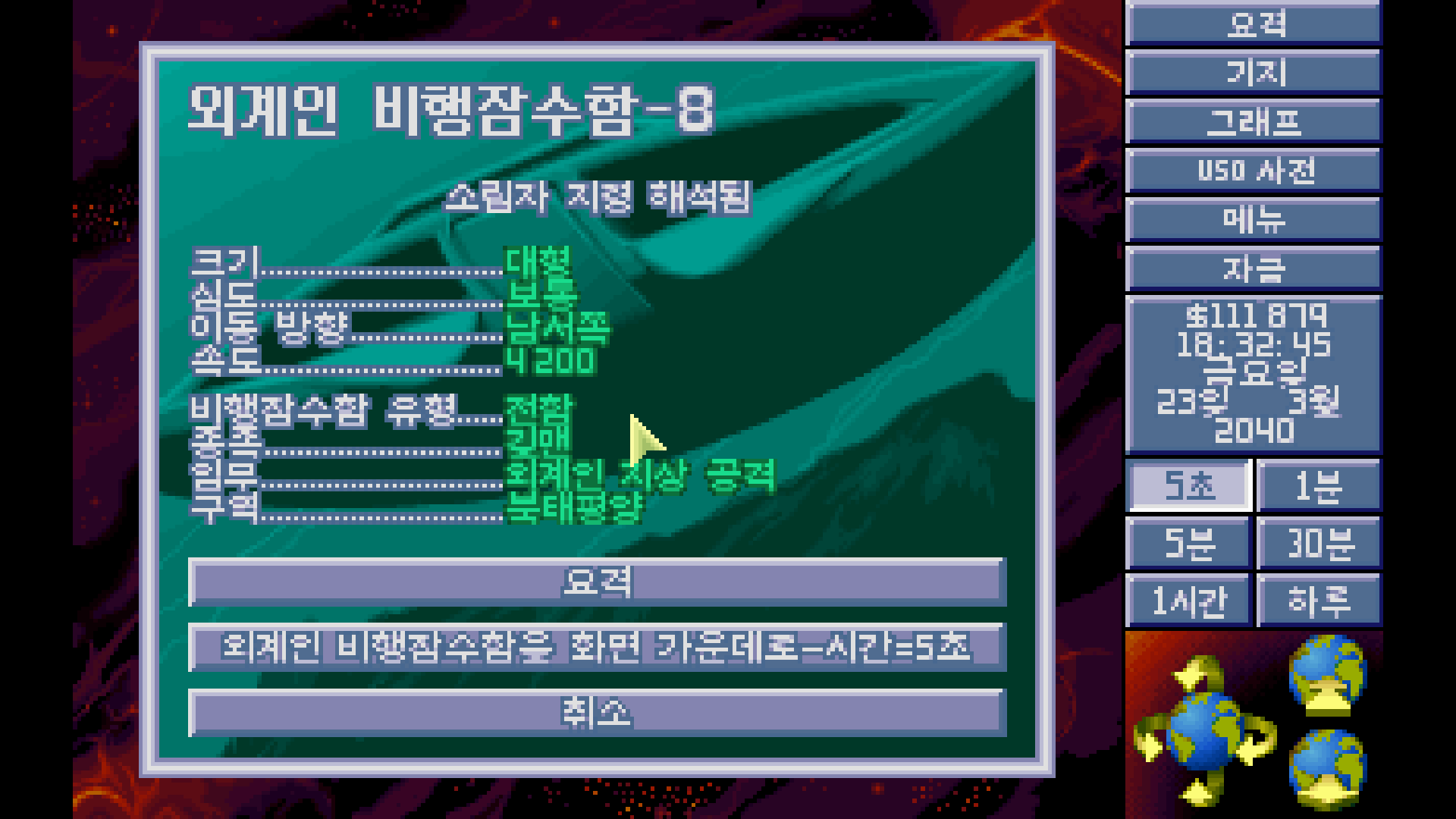

지령 해석기가 탐지를 해줬다. 함대 보급 순양함? 엄청 큰 거 아닐까?

쫓아가봤는데 어차피 소실됐다.

.

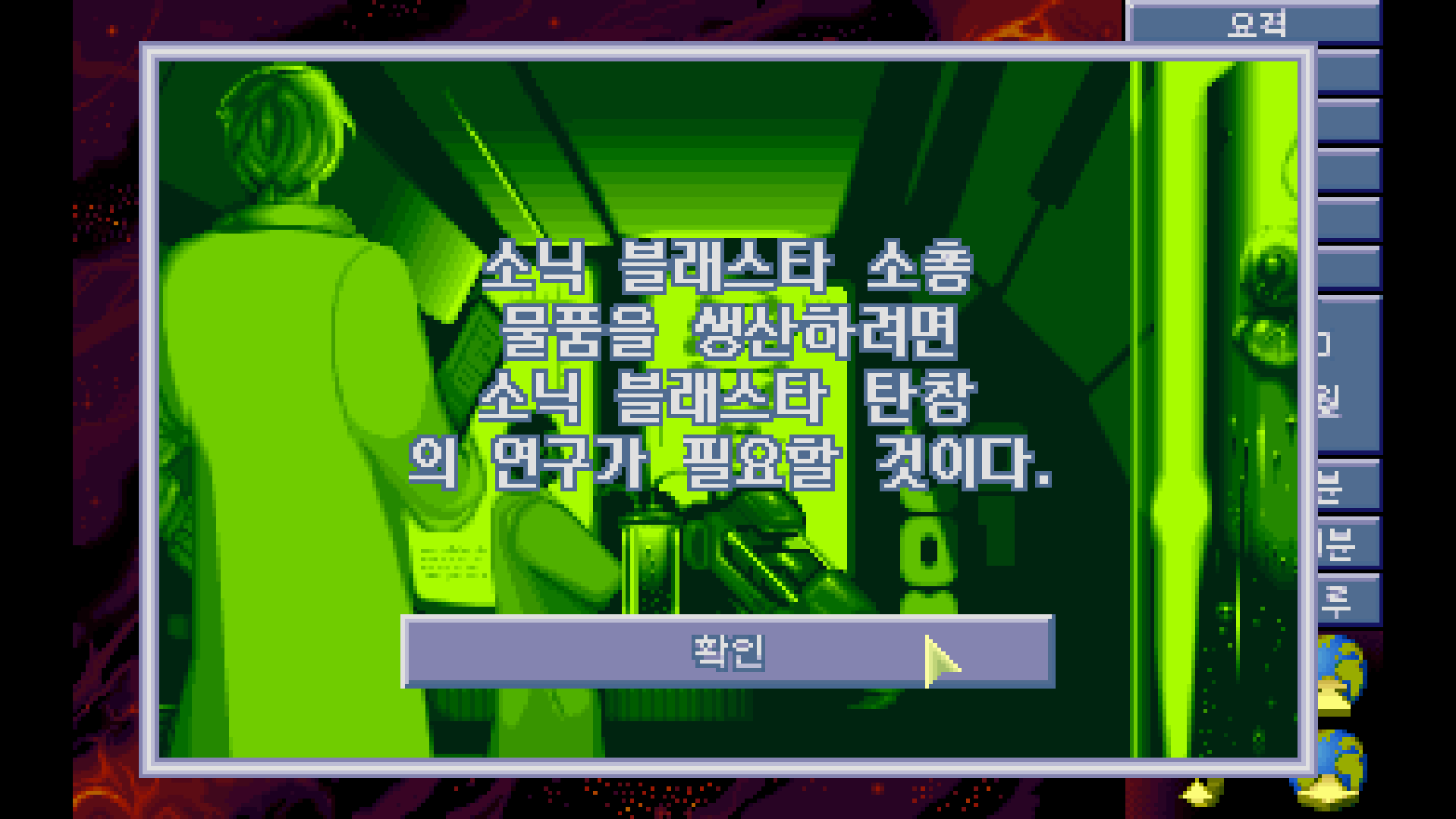

소닉 블래스타 소총의 연구가 완료됐다.

.

소닉 블래스타 탄창

의 연구가 필요할 것이다.

이 이상한 개행이 묘하게 킹받아 좋아하는 부분이다.

.

아놔 나 연구할 거 많은데~

.

이렇다고 한다. 공격을 해야겠지?

.

격침 완료!

.

이 게임에서 전투는.... 진짜 재미 없다. 왜지...

.

소닉 대포가 나왔다.

.

명중률은 꽤 높아보인다.

.

확실히 한 방에 잘 맞추는군!

.

사실 이런 전장도 문제다.

엄폐가 하나도 없기 때문이다.

움직이고 나서 내 안전이 보장되지 않는 개활지로

내 병사를 고기방패 던지는 거랑 다름없다.

.

.

돈을 좀 모아서 기술자를 더 사자.

.

잔뜩 사버려

.

지상 공격하러 전함이 왔다...라. 이건 아마 테러 사건이겠다.

.

아까 보낸 요격기 하나로는 털렸고. 두 번째 요격기를 보내보자.

는 지나가버렸다...

.

기술자를 더 넣어줬다.

.

소닉 블래스타 탄창 연구 완료.

.

그렇다고 한다.

.

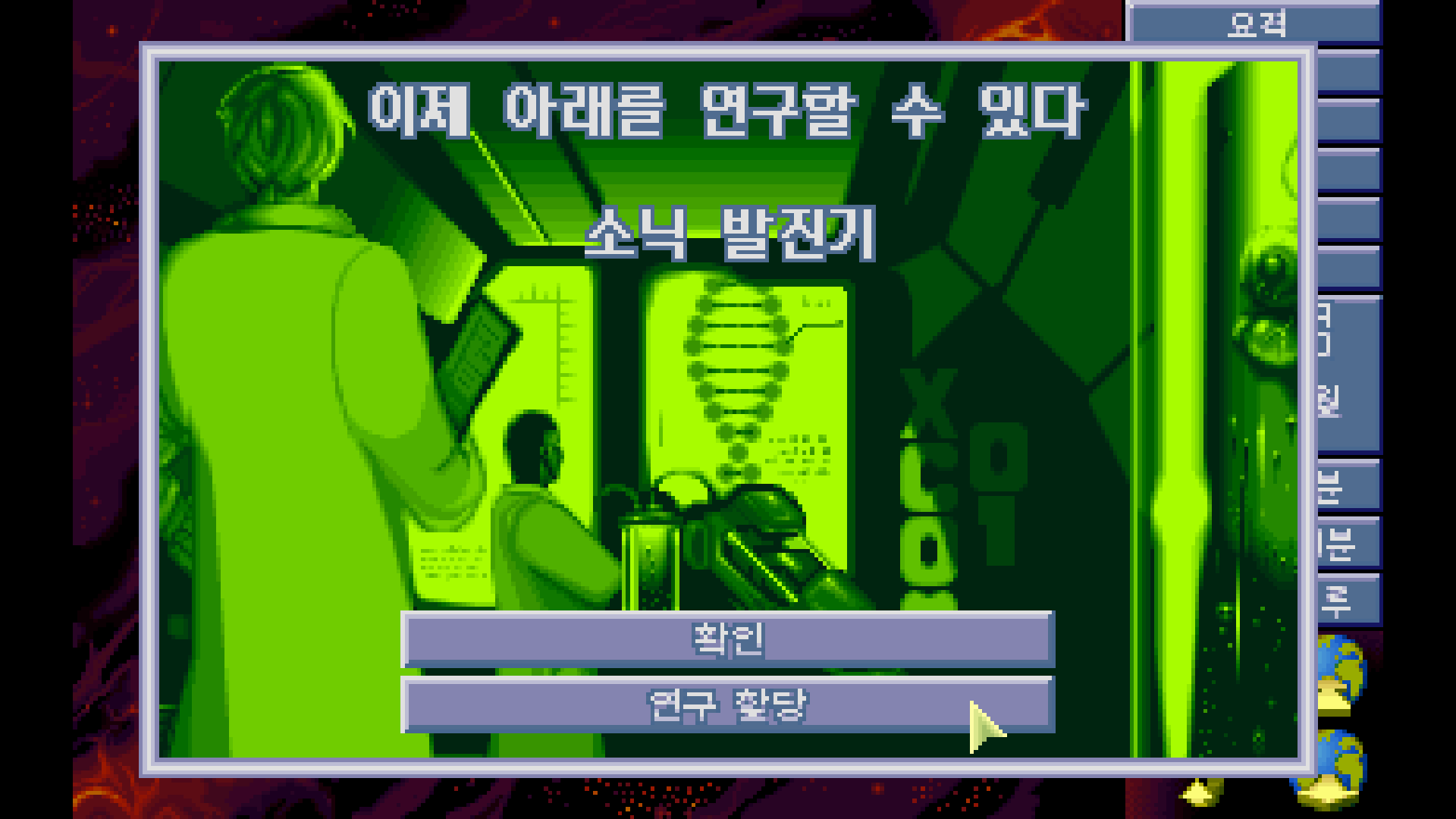

소닉 발진기의 연구가 풀렸다!

.

소닉 펄서와 통신 해석기를 마친 후, 소닉 무기 및 탄창(Sonic weapon & clip) 시퀀스를 시작하여 소닉 발진기(Sonic Oscillator) 함선 무기를 가능한 한 빨리 얻는 것을 목표로 하십시오. 소닉 발진기는 게임을 진행하는 데 필수적입니다. 외계 함선은 금세 너무 강해져서 그것 없이는 격추할 수 없습니다. 격추가 줄어들면 임무가 줄어들고, 진행이 제한되며, 미래는 암울하고 짧아질 뿐입니다. 정신 제어(M.C.)와 방어구 없이 전투 임무를 치르는 것이, 아예 전투 임무가 없는 것보다는 낫습니다! 소닉 캐논(Sonic Cannon)과 탄창을 먼저 연구해서 전투에 사용하는 것도 좋습니다. (그러나 이는 매우 비싼 전술일 수 있습니다. 차라리 소닉 캐논을 현금으로 팔아 X-Com의 역량을 키우는 것이 더 나을 수 있습니다.)

이것을 반드시 연구해야겠다.

.

| TFTD (7) 소닉 발진기 제작 (0) | 2025.09.13 |

|---|---|

| TFTD (5) 소닉 무기 개발개발 (0) | 2025.09.12 |

| TFTD (4) 250만원 어디다 써야하냐 (0) | 2025.09.12 |

| TFTD (3) 아쿠아토이드, 길맨, 딥원 (0) | 2025.09.12 |

| TFTD (2) 짱박히는 적과 불합리한 난이도 (0) | 2025.09.12 |